Entretien avec Jean-Louis Giavitto

Directeur de recherche au CNRS, Jean-Louis Giavitto travaille principalement sur la représentation et la manipulation d’objets musicaux, tant au niveau de l’analyse musicale et de la composition que de la performance sur scène. Il nous expose les enjeux cruciaux que soulève l’irruption de l’intelligence artificielle dans la boîte à outils du compositeur…

Quand et pourquoi les équipes de recherche de l’Ircam ont-elles commencé à s’intéresser à l’intelligence artificielle en tant qu’outil d’aide à la création musicale ?

D’une certaine manière, les chercheurs de l’Ircam s’y sont toujours intéressés. Seulement, pendant longtemps, les approches algorithmiques dites symboliques (s’appuyant sur la modélisation des phénomènes pour obtenir un résultat) ont donné de meilleurs résultats que les approches connexionnistes (s’appuyant sur l’apprentissage de réseaux de neurones), tout simplement parce que ces dernières nécessitent un accès à des quantités astronomiques de données, et à une puissance de calcul qu’on n’avait pas. Les algorithmes d’apprentissage n’étaient de surcroît pas encore au point (on ne savait par exemple pas faire apprendre efficacement des réseaux profonds, ceux qui présentent de nombreuses couches de neurones). Tout cela fait que le véritable printemps de l’intelligence artificielle par apprentissage profond de réseaux de neurones n’a commencé qu’au début des années 2000. Tout d’un coup, ces algorithmes d’apprentissage « brutal » ont permis un véritable bond en avant dans la résolution de problèmes sur lesquels les approches symboliques adoptées par les chercheurs du domaine, avec leurs connaissances expertes, avaient atteint une forme de plafond de verre.

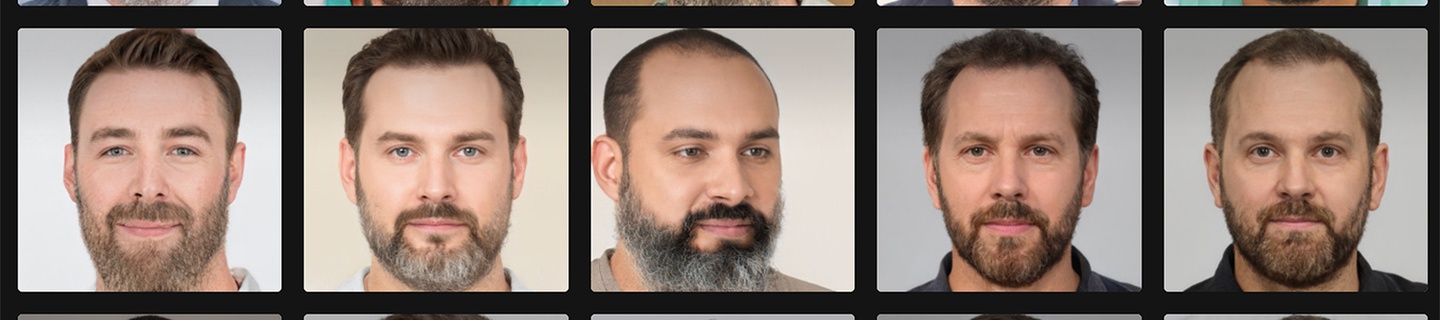

Visages synthétiques produits par des techniques d'apprentissage profond à partir d'un vrai visage generated.photos/anonymiser

Quels problèmes en particulier en ont bénéficié et pourquoi ?

Principalement les phénomènes dans lesquels des fonctions complexes interviennent. Avec l’approche symbolique, on essaie de modéliser le phénomène en cristallisant les observations expérimentales en lois scientifiques et en les reproduisant par nos algorithmes. Si je prends l’exemple de la voix, on sait qu’on a une source, le larynx, et un résonateur, la bouche. On sait assez bien modéliser l’un et l’autre séparément – le problème est de les lier. La « fonction de couplage », comme on l’appelle, est extrêmement complexe (notamment parce que le son produit rétroagit sur ce couplage). Elle peut être calculable, mais la programmer sous une forme explicite est quasi inatteignable. On pourrait résumer ça en disant que le monde réel peut peut-être se décrire mathématiquement, mais les fonctions qui permettraient de le faire sont moches, difficiles à décrire, avec beaucoup de cas particuliers.

L’apport principal de l’IA est de s’affranchir de cette étape de la modélisation. La machine apprend, sans qu’on n’ait rien à lui décrire. On s’évite donc le travail le plus crucial et le plus complexe : la formulation. On se contente de donner des tas d’exemples. D’une certaine manière, l’IA fait exactement l’inverse de ce qu’ont tenté de faire les scientifiques jusqu’à aujourd’hui : au lieu de s’appuyer sur un décryptage des règles de base du monde pour en recréer la diversité, elle apprend de la diversité du monde pour en produire de nouvelles. Regarder ce qui se passe dans le monde prend aujourd’hui moins de temps que de le simuler à partir des principes premiers.

Quels outils cette nouvelle approche permet-elle de développer ?

En vérité, ces outils, ou du moins leur usage, existaient déjà auparavant ! Par exemple, on faisait déjà de la synthèse vocale, mais cette nouvelle approche permet de la faire mieux. Elle donne des outils plus simples et plus puissants, plus faciles d’accès pour les compositeurs. Cela peut aussi changer la vie des ingénieurs du son, avec des outils de production, de nettoyage de signal, de mixage…

Vous voulez dire que, comme Monsieur Jourdain, nous utilisons de l’IA sans le savoir ?

Tout à fait : l’IA est enfouie dans bien des outils d’aide à la création aujourd’hui.

Les compositeurs et /ou les musiciens ont-ils des demandes spécifiques ?

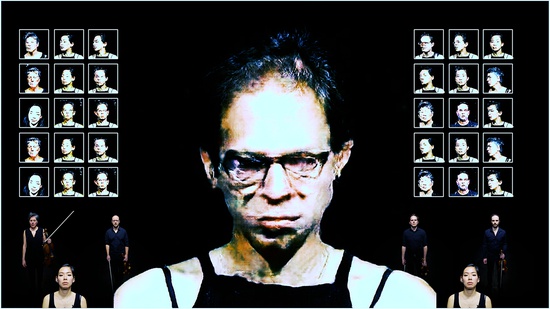

Elles sont nombreuses, à commencer par la synthèse sonore, et particulièrement la synthèse vocale (nous accueillons en ce moment en résidence de recherche artistique la plasticienne Judith Deschamps qui aspire à recréer une voix de castrat). Mais, de ce que j’en vois, c’est surtout l’objet, le concept en lui-même qui les interroge. Pour le moment, bien des compositeurs s’intéressant à l’IA ont surtout cherché à la mettre en scène, dans leur œuvre, plus comme un argument que comme un outil. C’est ce qu’a fait Daniele Ghisi dans La Fabrique des monstres, en nous donnant à entendre la machine en train d’apprendre, avec l’émergence à sa sortie d’un discours musical de plus en plus structuré. Ce qui l’intéresse, c’est donc plus le processus d’apprentissage que le résultat final. Pareil pour Alexander Schubert dans son spectacle Anima. Peut-être est-ce un phénomène normal : on découvre tout juste l’objet…

Justement, quels sont les fantasmes, quelles sont les réalités ?

Certains compositeurs s’inquiètent d’une possible production automatique de musique – alors que d’autres paradoxalement la cherchent ! Je crois que c’est un faux problème, dans un sens comme dans l’autre. Aujourd’hui, il existe déjà des gens qui produisent de la musique au kilomètre, principalement de l’illustration sonore. L’IA est ou sera prochainement capable de le faire, aussi bien, et aussi de produire de la musique pour accompagner des vidéos, en suivant par exemple l’arc dramatique suggéré par l’image. Mais je crois que l’IA est pour l’instant incapable de produire une musique véritablement expérimentale. Tout simplement parce que la musique expérimentale est moins balisée, puisque non régie par des grands principes clairement établis (comme l’harmonie tonale).

Certains compositeurs s’inquiètent d’une possible production automatique de musique – alors que d’autres paradoxalement la cherchent ! Je crois que c’est un faux problème, dans un sens comme dans l’autre. Aujourd’hui, il existe déjà des gens qui produisent de la musique au kilomètre, principalement de l’illustration sonore. L’IA est ou sera prochainement capable de le faire, aussi bien, et aussi de produire de la musique pour accompagner des vidéos, en suivant par exemple l’arc dramatique suggéré par l’image. Mais je crois que l’IA est pour l’instant incapable de produire une musique véritablement expérimentale. Tout simplement parce que la musique expérimentale est moins balisée, puisque non régie par des grands principes clairement établis (comme l’harmonie tonale).

Par ailleurs, cela pose le problème crucial des données : la logique musicale s’est, depuis un siècle, démultipliée et singularisée. Chaque compositeur développe la sienne propre, différente du voisin. Ce qui signifie beaucoup de mondes à parcourir pour l’IA et moins de données sur chacun d’eux. L’IA aura donc du mal à s’imbiber de la logique à l’œuvre, et ce qu’elle produira sera proche du hasard. Bref, on peut certes produire ainsi de la musique, mais celle-ci ne sera pas forcément intéressante et n’explorera de nouveaux territoires que par accident. Pour un compositeur, comme pour un auditeur du reste, qu’une machine compose de la musique à la manière de Bach, peu lui chaut.

Photo : Convergence d'Alexander Schubert © Alexander Schubert

Quels sont selon vous les risques de telles technologies ?

Les mêmes que toute technologie : l’effet normatif. En facilitant la vie des artistes, les technologies ont tendance à harmoniser les esthétiques – une tendance qui est encore amplifiée par la nature même de l’apprentissage profond. Mais ce danger normatif est-il plus fort que celui que présentent la machine média, le regard du public ou la mondialisation ? Accéder à toute la musique du monde n’aide pas à produire de la musique nouvelle. Cela exige au contraire des compositeurs un cheminement singulier, une forme d’expérimentation, des écarts, mais qui ne prennent leur sens que par l’histoire et le paysage dans lesquels ils s’inscrivent.

À l’inverse, cela peut s’avérer un atout et l’IA peut justement servir à cela : donner à entendre une norme émergente. La machine apporte à la fois une extériorité (ce n’est pas un humain qui a composé cela) et une focalisation sur nos idiosyncrasies (l’apprentissage capture ce qui est récurrent dans un corpus). En cela, la machine fera sans doute « bouger les lignes » : quels sont les enjeux de la composition pour un humain quand une machine aussi peut composer ?

Quelles sont les pistes de recherche autour de ces systèmes au sein de l’Ircam ?

Nombreuses. Dans le domaine de l’analyse-synthèse, les systèmes d’intelligence artificielle, même sommaires, ont changé la donne s’agissant de nettoyer des voix, de séparer des sources sonores, d’automatiser le mixage, d’indexer et de caractériser de vastes catalogues. Dans le même ordre d’idées, l’intelligence artificielle peut nous aider à déterminer les meilleurs paramètres d’un synthétiseur donné pour approcher un son cible. Idem pour l’orchestration. On peut même apprendre à l’ordinateur comment orchestrer une partie de piano à partir d’un corpus donné (correspondant à un répertoire ou un compositeur…) et ainsi orchestrer, par imitation et sans jamais expliciter les règles sous-jacentes, un discours pianistique.

Voyez-vous d’autres potentiels horizons à explorer ?

J’ai peu de retours de la part d’instrumentistes ou performeurs, mais de nombreux outils sont potentiellement développables, comme des « Autotune » pour instruments, facilitant son contrôle et le geste instrumental. On a connu également de grandes avancées dans le domaine des agents improvisateurs (la machine improvise avec des partenaires humains). Avec ces systèmes, le rôle de l’ordinateur excède celui d’un outil pour aller vers un compagnonnage musical. En utilisant des agents improvisateurs pour son spectacle Music of Choices, le compositeur Alexandros Markeas a voulu créer de la musique autrement, ce qui a eu pour conséquence de l’amener à revoir la forme du concert et de redistribuer les rôles entre le musicien, les auditeurs et la machine. Ces agents improvisateurs fonctionnent à partir d’une « mémoire », une librairie de sons que l’on enrichit à sa guise. Pour l’instant, ce sont les musiciens qui choisissent ce qu’ils y mettent, et la machine se nourrit ensuite de tout ce qui se passe sur scène au cours de la performance. Mais que se passerait-il si on ne vidait jamais cette mémoire ? Si cette librairie pouvait passer d’un artiste à un autre, se nourrissant de concert en concert, comme un musicien qui n’oublierait jamais rien. En s’inscrivant ainsi dans une histoire, cette librairie deviendrait un véritable compagnon créatif, s’individuant et se différenciant des autres librairies.

Music of Choices, spectacle d'Alexandros Markeas, Festival ManiFeste-2022 © Ircam-Centre Pompidou, photo : Quentin Chevrier

Music of Choices, spectacle d'Alexandros Markeas, Festival ManiFeste-2022 © Ircam-Centre Pompidou, photo : Quentin Chevrier

C’est bien sûr une expérience de pensée mais, chacun s’appropriant les outils à sa manière, en leur assignant des structures opératoires propres, le compagnon évolue : comment dès lors accueillir ses propositions ? L’enjeu pour les compositeurs est donc d’imaginer de nouvelles manières de travailler avec la machine, de « rompre les règles dans l’acte qui les fait jouer ».

Au-delà de leurs applications, quelles sont les pistes d’amélioration de ces systèmes apprenants dans le cadre d’une aide à la création ?

Cela passe principalement par une amélioration des algorithmes d’apprentissage (en affinant leurs réglages, ou, plus largement, via les choix d’architecture des réseaux), mais aussi par une attention particulière portée aux corpus desquels le système apprend, qui ont également une influence significative sur les résultats. L’un des grands enjeux est de casser la « boîte noire » que représente aujourd’hui l’IA : en sachant expliquer son fonctionnement, on est mieux à même de la programmer et de la contrôler. Cela paraît à la fois contrintuitif et ironique : il faudrait à présent adopter une approche symbolique de cet outil qui nous a permis de nous affranchir d’une approche symbolique des phénomènes. C’est en effet une grande question : l’intelligibilité doit-elle passer par le symbolique ?

Au reste, il en va de même pour l’art : l’art est-il intelligible par le biais de la symbolique ? Ou parle-t-il directement à nos sens ? L’art ne devrait-il pas être une monstration, plus qu’une démonstration, sans cesse disséqué et analysé ? L’intelligence artificielle serait-elle alors à cet égard plus « artiste » que nous, puisqu’elle fait sans donner à comprendre ? On constate que l’intelligence artificielle nous force à reconsidérer des problèmes artistiques, philosophiques, anthropologiques, anciens, d’un autre point de vue.

Propos recueillis par Jérémie Szpirglas